GPT,即生成式预训练 Transformer 模型(Generative Pre-trained Transformer Model),是一种基于深度学习的技术。它通过在大规模文本语料库上预训练,使模型能够捕捉语言中的复杂模式和结构。GPT 模型的核心是 Transformer 架构,这是一种基于自注意力机制的神经网络,能够有效地处理序列数据。GPT 模型通过无监督学习的方式学习语言特征,然后可以用于生成文本、回答问题、翻译等多种自然语言处理任务。它预训练的过程不需要人工标注数据,这使得 GPT 模型在处理大规模数据时具有很高的效率和灵活性。此外,GPT 模型在生成文本时能够保持连贯性和逻辑性,从而在各种自然语言生成应用中显示出强大的能力。随着技术的不断发展,GPT 模型在智能客服、文本摘要、对话系统等领域得到了广泛应用。

-

玩家测试GPT-4能力 瞬间作成网页版《俄罗斯方块》

科技网 | 2024-09-25 10:18:22 -

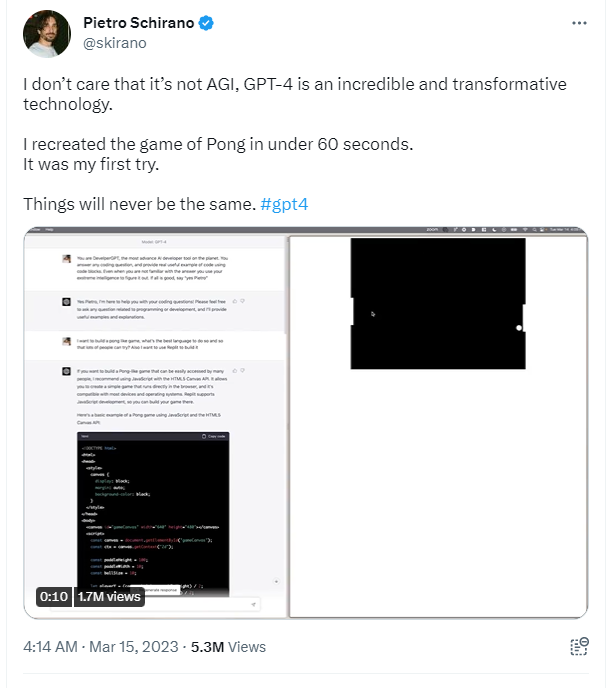

未来就在眼前 GPT-4 60秒内就能生成一款游戏

科技网 | 2024-09-25 10:21:42 -

MIT联合开发AI新技术 阅读乐高说明书学习组建MC模型

科技网 | 2024-09-30 12:48:47 -

韩国开发“动态难度模型” 根据玩家情绪调整游戏难度

科技网 | 2024-09-30 00:21:39 -

高达秘史解疑 模型招牌V型天线角为何既有白色又有黄色

科技网 | 2024-09-29 15:49:01 -

R18内容作者成功提取《守望先锋:归来》角色模型

科技网 | 2024-09-29 15:28:04 -

新加坡团队开发AI新工具 文本直接生产3DVR图像

科技网 | 2024-09-29 15:19:27 -

未来就在眼前 GPT-4 60秒内就能生成一款游戏

科技网 | 2024-09-25 10:21:42 -

玩家测试GPT-4能力 瞬间作成网页版《俄罗斯方块》

科技网 | 2024-09-25 10:18:22